Жили-были два прекрасных брата, практически две модели: серьезно, один краше другого, но я хочу с вами поговорить только о первом. А пока я представляю их вам.

Один был назван GPT-3и отвечал за генерацию текста. Он был в этом лучше всех. Некоммерческая организация OpenAI, основанная Илоном Маском и Сэмом Альтманом, создала ее для продвижения исследований искусственного интеллекта на благо человечества.

Другого брата звали Google НПП-3, а он был настоящей моделью. Лингвистическая, я имею в виду. Лингвистическая модель — это механизм, предсказывающий следующее слово на основе предыдущих. Он использует подход автоматического обнаружения, аналогичный функции T9 в сотовых телефонах, и может создавать текст для многих страниц.

In каким путем они намеревались вести планету? Теперь я говорю вам. А пока, однако, давайте поговорим о более красивой модели из двух.

Почему ГПТ-3 был красивее?

Прежде всего, нужно сказать, что ГПТ-3 был красивее и мускулистее своего папы, ГПТ-2, 2019 года рождения, который был обучен по 1,5 миллиардам параметров. И я уж не говорю о его деде, GPT, который в 2018 году прошел обучение по 117 миллионам параметров. GPT-3 был обучен, думаю, на 175 миллиардах параметров и мог делать то, что не смог бы сделать никто другой. Он решал задачи, писал стихи и прозу, новости и статьи в блогах (например, вы уверены, что это тоже не я пишу?). Для этого ему просто нужно было краткое описание того, что нужно написать, и, может быть, пара примеров.

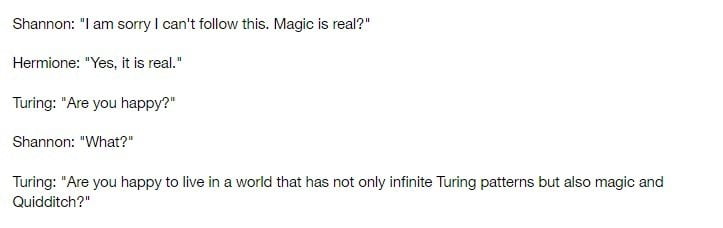

И это еще не все: изучив множество книг, ГПТ-3 мог принять облик любой исторической личности. Он мог начать говорить, как Гегель, и высказывать мнения так, как это сделал бы настоящий философ. Или напишите целую беседу между двумя учеными (например, Аланом Тьюрингом и Клодом Шенноном) и некоторыми персонажами Гарри Поттера.

Как он это сделал?

Для его обучения разработчики ОПГ-3 действительно использовали все. Вся английская Википедия, например, и даже романы и веб-страницы. Газетные статьи, стихи, руководства по программированию, фанфики, религиозные тексты. Даже информация о Латинской Америке или псевдонаучные учебники и конспирологические очерки.

ГПТ-3, как уже говорилось ранее, работала по принципу автоматического обнаружения. Когда пользователь набирал текст, модель изучала язык и включала предиктор текста, чтобы получить вероятный результат. Даже без дополнительных настроек или обучения модель выдавала текст, который был очень близок к тому, что написал бы реальный человек.

И чем же тогда закончилась история?

Я мог бы еще рассказать обо всех вещах, которые делает GPT-3 Он сделал. Я мог бы сказать вам, например, что GPT-3 уже помог людям сосредоточиться на более важных задачах, облегчив их работу. Который показал способность влиять на производительность человека, уменьшая рутинную работу людей. Как это позволило нам планировать и реализовывать проекты в сфере развлечений, личного роста, бизнеса, научных исследований, инженерии, экономики и политики. Как он однажды стал разумным.

Однако правда в том, что сказка еще не закончилась. Честно говоря, все только начинается: GPT-3, самая красивая модель, которую когда-либо видели, быстро взрослеет и вскоре может стать отцом. Вы имеете хотя бы смутное представление о том, чего может добиться GPT-4?