Как будто 2020 год не был достаточно катастрофическим, команда ученых, политических экспертов и специалистов по искусственному интеллекту предупреждает нас о проблемах на горизонте. 18, если быть точным. Это главные угрозы ИИ, о которых нам следует беспокоиться в ближайшие 15 лет.

Научная фантастика и популярная культура хотят, чтобы мы поверили, что наша гибель будет вызвана бунтом разумных роботов. Фактически один недавнее обучение в криминалистике показывает, что самая серьезная угроза будет больше связана с нами, чем с самим искусственным интеллектом.

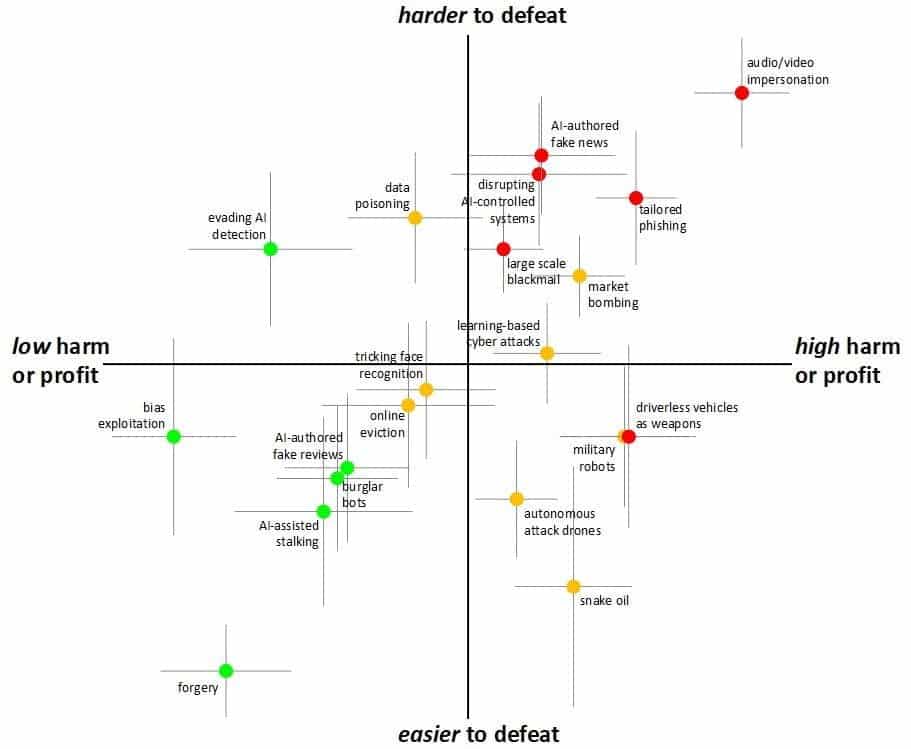

Оценивая угрозы на основе потенциального вреда, прибыльности, жизнеспособности и поражения, группа определила, что deepfake, технология, которая уже существует и распространяется, представляет наивысший уровень угрозы.

Дипфейк, враг номер один

Существует фундаментальная разница между восстанием роботов и технологией дипфейков. Первое может причинить материальный ущерб. Второе носит системный характер: оно может вызвать эрозию доверия к людям и к самому обществу.

Худшая угроза ИИ всегда может показаться чем-то далеким в будущем. В конце концов, как ИИ может нам навредить, если Алекса сегодня даже не может правильно установить таймер для макарон? Шейн Джонсон, директор Центра Дауэса по будущим преступлениям при Калифорнийском университете, который финансировал исследование, объясняет, что эти угрозы будут становиться все более изощренными и переплетаться с нашей повседневной жизнью.

«Мы живем в постоянно меняющемся мире, который создает новые возможности, хорошие и плохие», предупреждает Джонсон. «Это делает приоритетом предвидение будущих угроз преступности, чтобы политики и другие лица, обладающие необходимым опытом, могли сделать это до того, как возникнут серьезные проблемы».

Авторы признают, что суждения, высказанные в этом исследовании, по своей сути спекулятивны по своей природе и зависят от нашего нынешнего политического и технического ландшафта, но нельзя игнорировать будущее этих технологий.

Как родился «плейлист» самых страшных угроз

Чтобы сформулировать свои прогнозы на будущее, исследователи собрали команду из 14 ученых в смежных областях, семи экспертов частного сектора и 10 экспертов государственного сектора.

Затем этих экспертов разделили на группы по четыре-шесть человек и дали список потенциальных проблем, которые может создать ИИ. Сценарии варьируются от физических угроз (атаки автономных дронов) до цифровых форм угроз, таких как фишинг.

Чтобы сделать свое заключение, команда рассмотрела четыре основных характеристики атак:

Возможный ущерб

рентабельность

осуществимость

уязвимость

Для экспертов ущерб от дипфейка будет материальным, моральным и даже социальным. Они также могут нанести вред другим искусственным интеллектам (например, уклоняясь от распознавания лиц) или быть косвенными плодами (например, шантажировать людей с помощью глубокого подделки видео).

Хотя эти факторы на самом деле невозможно отделить друг от друга (например, вред от атаки может фактически зависеть от ее осуществимости), экспертам было предложено рассмотреть влияние этих критериев отдельно.

Затем оценки различных экспертных групп были ранжированы, чтобы определить в целом наиболее разрушительные атаки, которые мы можем увидеть с помощью ИИ (или с помощью ИИ) в ближайшие 15 лет.

Избалованный выбором

Как уже упоминалось, сравнивая 18 различных типов угроз ИИ, группа определила, что манипуляции с видео и аудио в форме дипфейков являются наихудшими угрозами за всю историю.

«Люди имеют сильную склонность верить своим глазам и ушам. Вот почему аудио- и видеодоказательствам традиционно придавали большое значение (и зачастую юридическую ценность), несмотря на долгую историю обмана с помощью фотографий», — объясняют авторы. «Но недавние разработки в области глубокого обучения (и дипфейков) значительно увеличили вероятность создания фейкового контента».

Возможные последствия этих манипуляций?

От людей, обманывающих пожилых людей, выдавая себя за члена семьи, до видеороликов, призванных посеять недоверие к общественным и государственным деятелям. Атаки, которые трудно обнаружить отдельным людям (а в некоторых случаях даже экспертам) и которые трудно остановить.

К другим серьезным угрозам относятся автономные транспортные средства, используемые в качестве дистанционного оружия. Интересно, что группа сочла роботов-роботов (маленькие роботы, которые могут лазить по сточным канавам, чтобы украсть ключи или открыть двери для воров-людей) как одну из наименее опасных угроз.

Худшие угрозы ИИ. Итак, нам конец?

Нет, но над этим надо работать. На наших оптимистичных изображениях есть какая-то кнопка, чтобы остановить всех роботов и все злые компьютеры.

На самом деле угроза не столько в самих роботах. Это то, как мы используем их, чтобы манипулировать друг другом и причинять им вред.